Jupyter Notebook Python: guia completo do zero

O Jupyter Notebook é uma das ferramentas mais populares entre cientistas de dados, analistas e programadores Python. Mas será que você realmente precisa dele? E mais importante: está usando da forma correta?

Neste guia, você vai aprender não apenas o básico, mas entender os fundamentos que fazem toda a diferença na prática, desde quando usar (e quando evitar) até como organizar projetos profissionalmente.

Quando usar Jupyter Notebook e quando NÃO usar

Situações ideais para Jupyter Notebook

Análise exploratória de dados: quando você precisa visualizar dados rapidamente, testar hipóteses e iterar sobre transformações, o Jupyter é imbatível. A capacidade de ver resultados imediatamente, ajustar código e reexecutar apenas partes específicas acelera drasticamente o processo de descoberta.

Ensino e documentação: a combinação de código, texto formatado e visualizações torna o Jupyter ideal para criar tutoriais, aulas e documentação técnica. Você pode explicar conceitos, mostrar exemplos executáveis e incluir gráficos tudo no mesmo documento.

Prototipagem rápida: para testar algoritmos, validar ideias ou criar provas de conceito, o Jupyter permite experimentação ágil sem a estrutura formal de um projeto Python completo.

Situações onde Jupyter NÃO é a melhor escolha

Produção: notebooks não são adequados para sistemas em produção. Eles não foram projetados para serem executados automaticamente, não possuem controle de versão eficiente e dificultam testes automatizados.

Pipelines de dados: para ETL, processamento batch ou workflows automatizados, scripts .py são mais confiáveis, testáveis e fáceis de integrar com ferramentas de orquestração como Airflow ou Prefect.

Times grandes: quando várias pessoas trabalham no mesmo código, notebooks geram conflitos no Git devido ao formato JSON. A revisão de código também é mais difícil comparada a arquivos Python tradicionais.

Jupyter Notebook com IA: por que eles andam juntos?

O Jupyter Notebook se tornou praticamente um padrão de fato em projetos de IA e Machine Learning, especialmente nas fases iniciais de desenvolvimento.

Isso acontece porque modelos de IA exigem exatamente o tipo de fluxo que o Jupyter oferece:

-

Exploração intensa de dados;

-

Testes rápidos de features;

-

Ajustes iterativos de modelos;

-

Visualização constante de métricas, erros e gráficos.

Em tarefas como treinamento de modelos com scikit-learn, TensorFlow ou PyTorch, o notebook permite que você:

-

Teste diferentes arquiteturas e hiperparâmetros célula por célula;

-

Visualize curvas de perda, acurácia e matrizes de confusão imediatamente;

-

Documente decisões técnicas ao lado do código (algo essencial em projetos de IA responsáveis).

Além disso, ferramentas modernas de IA generativa como assistentes de código e AutoML são frequentemente usadas dentro do Jupyter, acelerando ainda mais a experimentação.

Embora o Jupyter seja excelente para treinar e avaliar modelos de IA, ele não deve ser o ambiente final de produção.

O fluxo profissional costuma ser:

Notebook → validação do modelo → refatoração para scripts Python → deploy em APIs ou pipelines automatizados.

Como funciona o Jupyter Notebook

Entender a arquitetura do Jupyter evita bugs frustrantes e torna você mais produtivo.

O que é um kernel (explicado de forma simples)

O kernel é o "motor" que executa seu código Python. Pense nele como uma sessão Python separada que mantém todas as suas variáveis, imports e definições de funções na memória.

Quando você abre um notebook, o Jupyter inicia um kernel nos bastidores. Esse kernel fica ativo enquanto o notebook está aberto, preservando o estado da sua análise. É por isso que você pode definir uma variável em uma célula e usá-la em outra o kernel mantém tudo na memória.

O que acontece quando você executa uma célula

Quando você pressiona Shift+Enter, o Jupyter envia o código da célula para o kernel, que:

-

Executa o código linha por linha;

-

Armazena variáveis e resultados na memória;

-

Retorna o output de volta para o notebook;

-

Exibe esse output logo abaixo da célula.

Esse processo é quase instantâneo para operações simples, mas pode levar tempo para análises complexas ou processamento de grandes volumes de dados.

Por que a ordem das células importa (e gera bugs)

Aqui está o problema que confunde iniciantes: você pode executar células em qualquer ordem, mas o kernel sempre mantém o último estado executado, não a ordem visual do notebook.

Imagine este cenário: você define x = 10 na célula 1, depois x = 20 na célula 2. Se você executar célula 2 e depois célula 1, o valor final de x será 10 mesmo que visualmente a célula 2 esteja abaixo.

Isso acontece porque o kernel executa comandos na ordem que você pede, ignorando completamente a posição das células no documento.

Esse comportamento causa bugs sutis quando você:

-

Executa células fora de ordem durante experimentação;

-

Deleta células que definiam variáveis importantes;

-

Compartilha notebooks sem reiniciar o kernel primeiro.

A solução? Sempre reinicie o kernel e execute todas as células em ordem antes de considerar seu notebook finalizado.

Instalação do Jupyter: 3 caminhos e qual escolher

Existem três formas principais de instalar o Jupyter, cada uma com vantagens específicas.

1. Via Anaconda (para iniciantes)

Como instalar: baixe o Anaconda no site oficial, instale e o Jupyter já vem incluído. Abra o Anaconda Navigator e clique em "Launch" no Jupyter Notebook.

Prós:

-

Instalação mais simples, tudo funciona "out of the box"

-

Inclui centenas de bibliotecas científicas pré-instaladas

-

Gerenciamento de ambientes através de interface gráfica

-

Ideal para quem está começando e não quer lidar com terminal

Contras:

-

Ocupa muito espaço em disco (vários GB)

-

Instala muitas bibliotecas que você pode nunca usar

-

Pode criar conflitos com instalações Python existentes

2. Via pip

Como instalar:

Prós:

-

Instalação leve e rápida;

-

Você controla exatamente quais bibliotecas instalar;

-

Funciona bem com ambientes virtuais (venv, virtualenv);

-

Integração natural com projetos Python existentes.

Contras:

-

Requer conhecimento básico de terminal;

-

Você precisa instalar bibliotecas adicionais manualmente;

-

Pode ter problemas de dependências em sistemas mal configurados.

Erros comuns: se aparecer "jupyter: command not found", o diretório de scripts Python não está no PATH do sistema. A solução geralmente é executar python -m notebook em vez de jupyter notebook.

3. Via VS Code

Como usar: instale a extensão "Jupyter" no VS Code. Crie um arquivo .ipynb e o VS Code automaticamente oferece executar células.

Prós:

-

Interface moderna e integrada com outras ferramentas;

-

Debugging superior ao Jupyter tradicional;

-

Controle de versão Git mais visual;

-

Autocompletar e IntelliSense melhores.

Contras:

-

Curva de aprendizado se você não conhece VS Code;

-

Algumas extensões Jupyter específicas não funcionam;

-

Performance pode ser menor em notebooks muito grandes

Células, kernel e outputs no Jupyter Notebook

Tipos de células (code vs markdown)

Células de código: contêm código Python executável. Reconhecíveis pelo prefixo In [ ]: à esquerda. Quando executadas, exibem resultados abaixo com o prefixo Out [ ]:.

Células markdown: contêm texto formatado, títulos, listas, links e até fórmulas matemáticas em LaTeX. Use-as para documentar seu raciocínio, explicar hipóteses ou estruturar seções do notebook.

Atalhos essenciais:

-

Esc + M: Transforma célula em markdown; -

Esc + Y: Transforma célula em código; -

Esc + A: Adiciona célula acima; -

Esc + B: Adiciona célula abaixo.

Outputs que "mentem" (estado antigo)

Um dos erros mais perigosos do Jupyter: outputs desatualizados. Quando você modifica código e não reexecuta a célula, o output antigo permanece visível, criando uma falsa impressão dos resultados.

Exemplo prático:

Se você alterar para dados = [10, 20, 30] mas não reexecutar, o output continuará mostrando 6. Você e outros leitores podem tomar decisões baseadas em informação incorreta.

Solução: use "Restart Kernel and Run All" regularmente para garantir que todos os outputs refletem o código atual.

Variáveis invisíveis que quebram análises

Outro problema sutil: variáveis definidas em células deletadas permanecem na memória do kernel. Seu código pode depender dessas variáveis "fantasma", funcionando perfeitamente para você mas falhando quando outra pessoa (ou você em outra sessão) executa o notebook do zero.

Fluxo correto para trabalhar com Jupyter (passo a passo)

1. Criar notebook com nome descritivo

Evite nomes genéricos e use nomes que descrevem o conteúdo:

-

analise_churn_outubro_2024.ipynb -

exploracao_dados_vendas.ipynb -

modelo_previsao_demanda_v2.ipynb

2. Estruturar com markdown logo no início

Comece seu notebook com:

-

Título em markdown (# Análise de Churn - Outubro 2024);

-

Objetivo da análise em 2-3 linhas;

-

Data e autor (facilita revisitar meses depois).

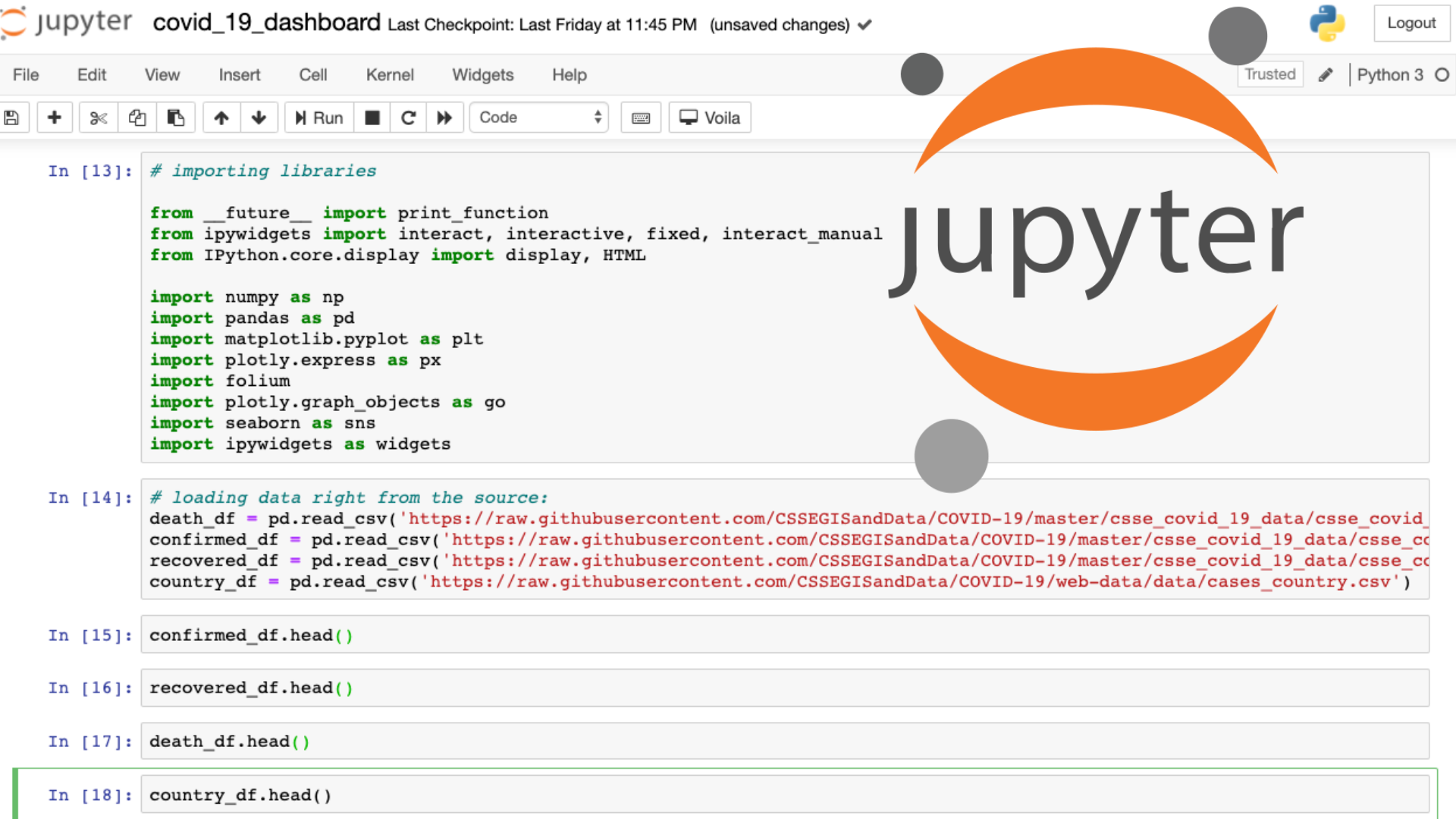

3. Imports organizados na primeira célula

Agrupe todos os imports no topo, divididos logicamente:

4. Documentar hipóteses e decisões

Antes de cada seção importante, use células markdown para explicar:

-

Qual pergunta você está tentando responder;.

-

Por que escolheu determinada abordagem;

-

Resultados esperados.

Isso é valioso tanto para revisão futura quanto para apresentar resultados a stakeholders.

Erros mais comuns de quem está começando (e como evitar)

1. Executar células fora de ordem

O erro: você executa célula 5, depois célula 2, depois célula 7. O notebook funciona para você, mas quebra quando alguém executa sequencialmente.

Como evitar: discipline-se a executar células de cima para baixo. Quando fizer alterações, use "Restart & Run All" para validar a ordem.

2. Não reiniciar o kernel durante desenvolvimento

O erro: você trabalha horas no mesmo notebook sem reiniciar o kernel, acumulando variáveis e estados antigos.

Como evitar: a cada mudança estrutural significativa (alterar lógica de limpeza de dados, modificar features), reinicie o kernel e reexecute.

3. Misturar análise exploratória com código final

O erro: seu notebook tem 200 células, metade são testes e experimentações, metade são análises finais. Impossível distinguir o que é importante.

Como evitar: crie notebooks separados para exploração e para análises finais. Ou use comentários claros como # TESTE - IGNORAR em células experimentais.

4. Confiar em outputs antigos

O erro: você vê um gráfico ou resultado numérico e toma decisões baseado nele, mas esse output foi gerado com dados ou código antigos.

Como evitar: sempre reexecute a célula antes de confiar no output, especialmente em análises críticas.

5. Não usar nomes descritivos para variáveis

O erro: variáveis como df1, df2, df3, x, y tornam o código impossível de entender semanas depois.

Como evitar: use nomes que descrevem o conteúdo: vendas_2024, clientes_ativos, taxa_conversao_mensal.

6. Carregar datasets grandes repetidamente

O erro: reexecutar células que carregam grandes arquivos CSV ou fazem queries pesadas ao banco de dados dezenas de vezes.

Como evitar: carregue dados uma vez no início e trabalhe com cópias (df_trabalho = df_original.copy()). Use células separadas para operações custosas.

7. Não versionar notebooks adequadamente

O erro: usar notebooks sem controle de versão ou fazer commits com outputs enormes que inflam o repositório Git.

Como evitar: use .gitignore para checkpoints do Jupyter. Configure Git para limpar outputs automaticamente antes de commits ou use ferramentas como nbstripout.

Jupyter Notebook vs Google Colab: qual escolher como iniciante?

| Critério | Google Colab | Jupyter Notebook (local) |

|---|---|---|

| Instalação | Não exige instalação. Basta acessar pelo navegador. | Requer instalar Python, Jupyter e bibliotecas. |

| Configuração de ambiente | Ambiente pronto e padronizado. | Pode exigir configuração e troubleshooting. |

| Hardware | Oferece GPU e TPU gratuitas para deep learning. | Depende totalmente do hardware da sua máquina. |

| Performance | Pode variar (latência de internet e recursos compartilhados). | Performance estável e dedicada ao seu computador. |

| Limite de tempo | Sessões podem ser encerradas após inatividade ou longas execuções. | Sem limite de tempo: roda indefinidamente. |

| Trabalho offline | ❌ Necessita internet constante. | ✅ Funciona totalmente offline. |

| Colaboração | Compartilhamento instantâneo via link (estilo Google Docs). | Compartilhamento manual de arquivos .ipynb. |

| Acesso em múltiplos dispositivos | Pode acessar de qualquer máquina (PC, notebook, tablet). | Limitado ao dispositivo onde está instalado. |

| Dados sensíveis | ❌ Dados ficam em servidores externos. | ✅ Dados permanecem na sua máquina. |

| Integração com projetos locais | Limitada. | Excelente integração com scripts, bancos e sistemas locais. |

| Indicado para iniciantes | ⭐⭐⭐⭐⭐ (mais simples para começar) | ⭐⭐⭐⭐ (melhor para evoluir profissionalmente) |

Conclusão

No fim das contas, o Jupyter Notebook não é “certo” ou “errado” por si só tudo depende de como você usa. Ele é excelente para exploração, ensino, documentação e prototipagem rápida, especialmente em projetos de IA e Machine Learning.

Mas, quando o assunto é produção, colaboração em larga escala e pipelines robustos, você precisa complementar (ou substituir) o notebook por uma estrutura mais profissional com scripts, testes e versionamento bem definidos.

Se você chegou até aqui, o próximo passo é continuar indo além: buscar sempre mais conhecimento do que você já tem hoje.